Bot-Konfiguration über robots.txt: Crawler effektiv steuern

Für jede:n Website-Betreiber:in ist die Textdatei robots.txt ein wichtiger Bestandteil für die Steuerung von Bot-Traffic. Mit ihr bestimmt der Publisher, welche Bots in welcher Form Webseiten crawlen und entsprechend bewerten. Im Folgenden erläutern wir die Bedeutung der robots.txt, auf was bei der Handhabung geachtet werden muss und welche Rolle KI-Bots heutzutage für Publisher spielen. Zusätzlich stellen wir klar, welche Rolle der Bot unseres Technologie-Partners Relemind im Hinblick auf Zuordnung des Inventars entsprechend der IAB 3.0 Taxonomie hat.

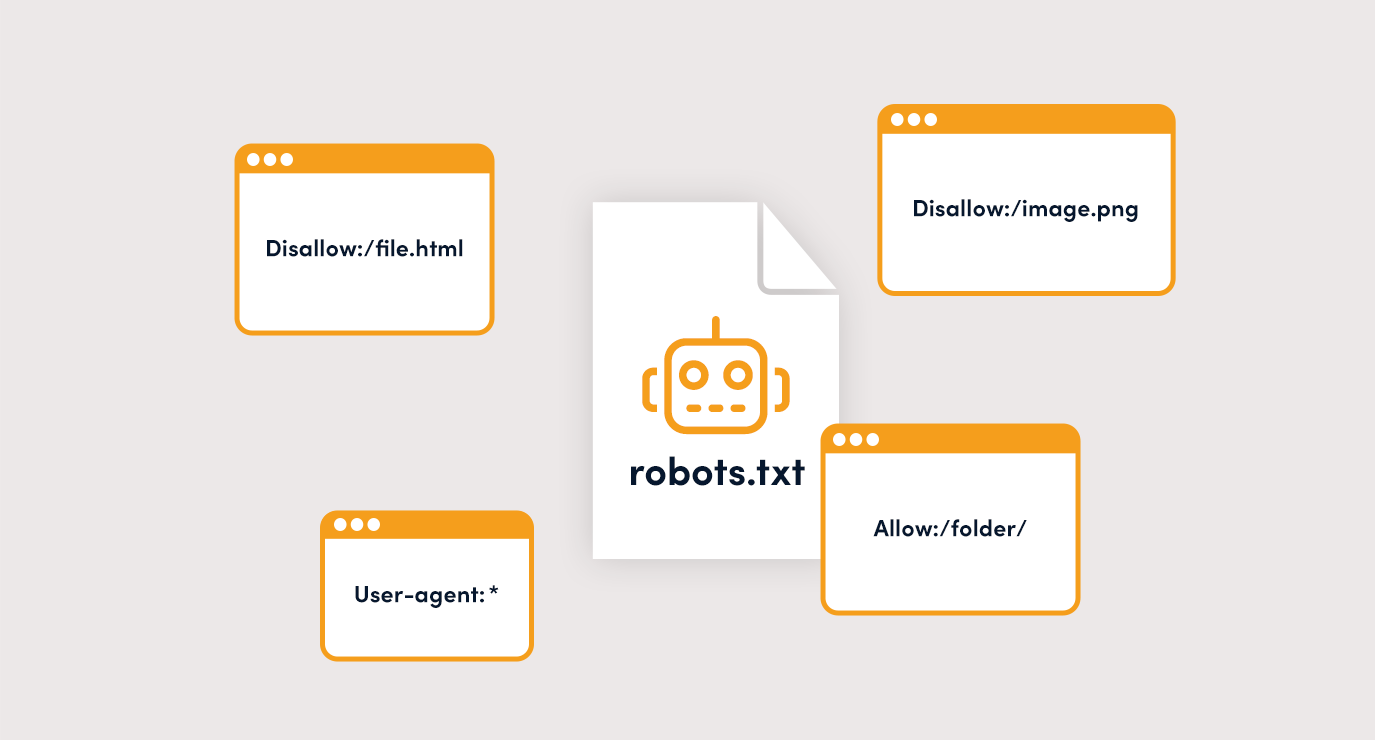

Einführung in die robots.txt – User Agents

Jede Website sollte über eine robots.txt-Datei verfügen, welche im Hauptverzeichnis liegt, auf welches die Domain zeigt. Wenn Du wissen möchtest, ob Du über eine solche Datei verfügst, kannst Du einfach /robots.txt an Deine Domain anhängen: https://www.deinewebsite.de/robots.txt

Die drei grundlegenden Funktionen einer robots.txt-Datei sind:

- User-Agent: Gibt den Robot-Namen an (z. B. Googlebot)

- Allow: Gibt einem Bot die Anweisung, die Website bzw. bestimmte Bereiche zu crawlen

- Disallow: Gibt einem Bot die Anweisung, die Website bzw. bestimmte Bereiche nicht zu crawlen

Newsletter abonnieren und nichts verpassen!

Warum ist es wichtig, die robots.txt zu konfigurieren?

Die robots.txt-Datei hilft Dir, Deine Website im Hinblick auf Suchmaschinen zu verwalten. Hierbei spielen verschiedene Aspekte eine Rolle.

- Steuerung des Crawl-Budgets

- Steuerung der Seiten die indexiert bzw. nicht indexiert werden sollen

- Inhalte wie PDFs, Bild oder Video-Dateien ausschließen

Auch wenn sich mit der robots.txt-Datei schädliche Bots nicht ausschließen lassen, so hilft sie einem Publisher dabei, guten Bots als Wegweiser zu dienen und die Inhalte entsprechend einzuordnen.

Das Crawling

Publisher möchten mit ihrer Website Geld verdienen. Hierfür ist stetiger Traffic von signifikanter Bedeutung. Organisch generierte Seitenaufrufe durch Suchmaschinen wie Google oder Bing bilden für die meisten Seitenbetreiber:innen das Fundament.

Ein gut genutztes Crawl-Budget erweist sich als wichtiger Hebel, um die Qualität der gecrawlten Seiten hervorzuheben. Eine große Anzahl gecrawlter Webseiten bedeutet nicht direkt positive Signale für die Suchmaschine, wenn die gecrawlten Inhalte keinen Mehrwert für die Leser:innen bieten.

Dementsprechend empfiehlt es sich, mit wachsender Anzahl an Unterseiten bzw. Blogartikeln zu schauen, welche Inhalte tatsächlich gecrawlt werden sollen und welche unter Umständen ausgeschlossen werden können.

Unwichtige oder veraltete Inhalte sollten grundsätzlich und unabhängig davon aber immer wieder auf den Prüfstand gestellt werden, im Rahmen einer Content Analyse. Hier kann es sich lohnen, veraltete und irrelevante Inhalte ganz zu löschen.

Allow/Disallow

Stellt sich nun die Frage, wie ich als Publisher Seiteninhalte per robots.txt ausschließe bzw. wie ich Bots mitteile, wie sie sich auf meiner Website verhalten sollen?

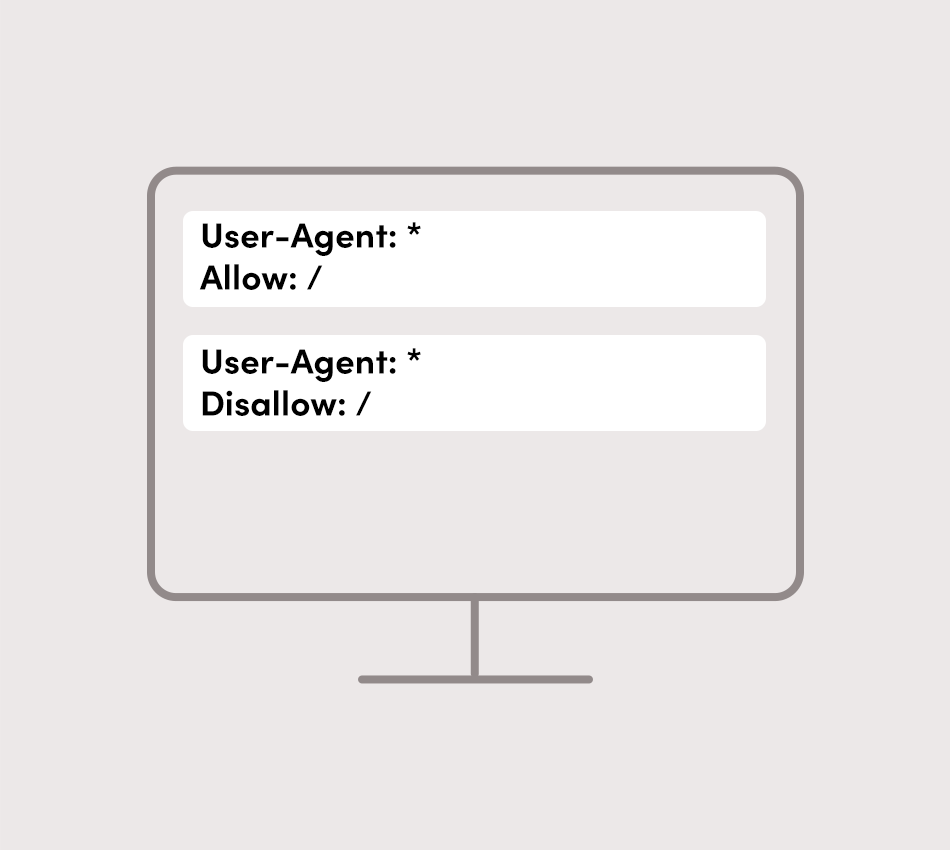

Die grundlegende robots.txt-Syntax, welche auch immer einen Verweis auf die Index Sitemap enthalten sollte, lautet wie folgt, je nachdem ob ein Bot die Seite crawlen soll (Allow) oder nicht (Disallow):

Nach diesem Schema lassen sich die entsprechenden Seiten für bestimmte Bots (z. B. Googlebot oder Bingbot) für die Indexierung in Suchmaschinen ein- oder ausschließen.

Genaue Konfiguration

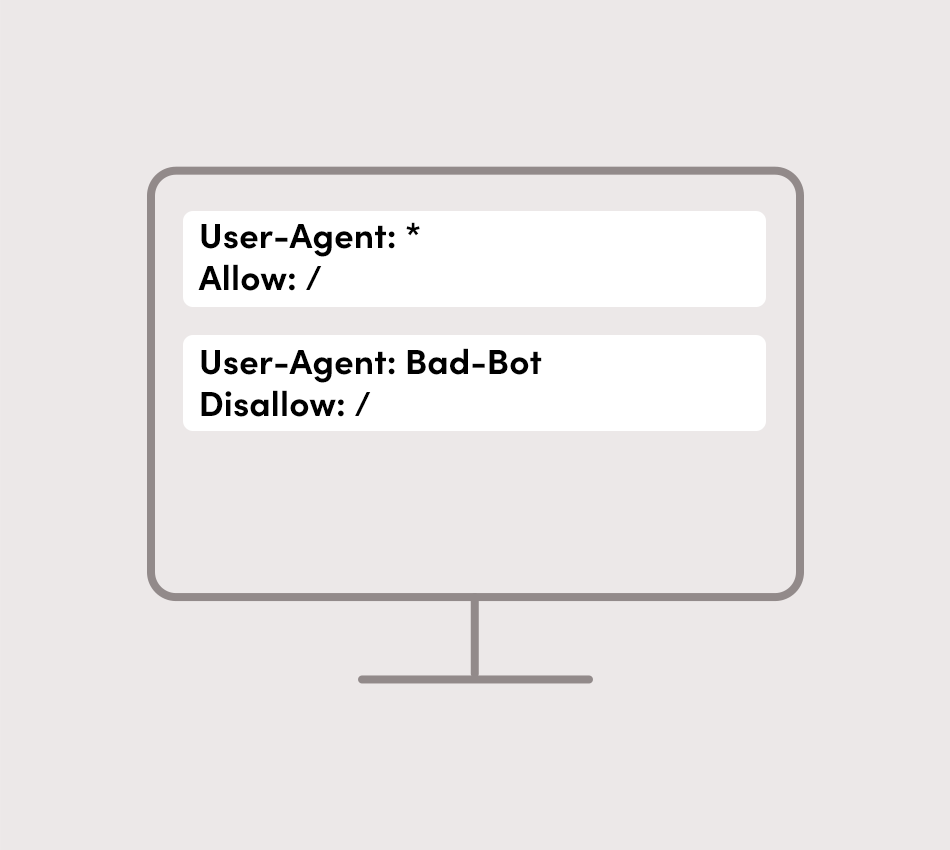

Um die Funktionsweise der robots.txt tiefergehend darzustellen, nutzen wir ein entsprechendes Beispiel:

- Hierbei nehmen wir an, dass die Website grundsätzlich von allen Bots gecrawlt und damit indexiert werden darf.

- Zudem schließen wir hier lediglich den Googlebot für das Crawling der Testseite aus, nicht aber die anderen Bots.

Sag Hi

Du möchtest Dein Blog oder Website monetarisieren? Kontaktiere jetzt unsere AdTech-Expert:innen!

Warum ist die robots.txt wichtig für SEO?

Wie eingangs erwähnt, zählt SEO für Publisher mit all seinen Teilbereichen zu den wichtigsten Aufgaben, um möglichst weit oben in Suchmaschinen zu ranken, um entsprechenden organischen Traffic zu generieren.

Die Handhabung der robots.txt zählt dabei zu den Aufgaben der technischen SEO. Dieser Bereich erfordert in der Regel ein hohes Maß an Expertise, die robots.txt-Datei kann vom Publisher allerdings unkompliziert selbst gepflegt werden.

Eine saubere robots.txt bildet für jede:n Website-Betreiber:in die Grundlage, um den eigenen, qualitativ hochwertigen Traffic in den Suchmaschinen listen zu lassen sowie nicht gewünschte Bots oder Unterseiten, die für die Besucher:innen keinen Mehrwert bieten, von der Indexierung auszuschließen.

Unerwünschte Bots in der robots.txt aussperren

Wie Du inzwischen weißt, wird mit dem Befehl Disallow einem Bot angezeigt, dass er bestimmte Seiten nicht crawlen soll. Befindet sich Deine Website zum Beispiel noch in der Entstehung, die Domain aber ist erreichbar, kannst Du mit folgendem Eintrag Deine Website vom Googlebot und damit der Indexierung in der Google-Suche ausschließen:

Leider ist es so, dass unerwünschte Bots, die darauf abzielen, Schaden anzurichten, sich immer besser tarnen und als herkömmliche Bots für organische Zugriffe verantwortlich sind.

In der Regel weisen zuverlässige Hoster hier sehr gute Vorkehrungen auf, um bspw. DDOS-Angriffe oder Bruteforce-Attacken zu verhindern. Zu den weiteren Möglichkeiten, um die eigene Website zu schützen, zählen:

- Alle verwendeten Plugins aktuell halten

- Bot-Sperren wie Captcha einrichten

- Zugriffe über .htacces-Daten konfigurieren

KI-Bots: Erlauben oder ausschließen?

Spätestens seit 2023 spielt Software für generative KI, wie ChatGPT, Midjourney oder Gemini, in der breiten Masse eine tragende Rolle. Publisher müssen sich seither damit auseinandersetzen, ob sie ihren generierten Content auch für KI-Bots zugänglich machen möchten oder diesen ausschließen. Wird sich für einen Ausschluss entschieden, bedeutet das primär, dass KI-Software die eigenen Daten nicht als Trainingsdaten verwenden kann.

Die Gefahr durch KI-Bots (sowie anderer Bots) besteht darin, dass der eigene Content, der eigenständig und aufwändig recherchiert und geschrieben wurde, zweckentfremdet wird. Möglicher Duplicate Content ist nur eine der negativen Folgen.

Mit folgendem Eintrag schließt Du einen der gängigsten KI-Bots, den GPTBot, für das Crawling Deiner Website aus:

Auf der anderen Seite kann das Erlauben von KI-Bots in Deiner robots.txt auch dafür sorgen, dass KI-Software sich schneller weiterentwickelt und qualitativ hochwertigere Ergebnisse liefert. Dies kann dabei helfen, wenn man auf künstliche Intelligenz, z. B. für die Erstellung einer Blogstruktur, Metadaten etc. zurückgreifen möchte, um eigene Ressourcen zu sparen, was ein Argument ist, KI-Bots nicht grundsätzlich auszuschließen.

Mit dem Relemind-Bot Contextual Targeting ermöglichen

Ein für unsere symplr-Kund:innen wichtiger Bot ist der Relemind-Bot unseres Technologie-Partners. Mit Hilfe des Relemind-Bots findet eine Zuordnung des Anzeigeninventars entsprechend der IAB 3.0 Taxonomie statt. Dies ist für uns Grundvoraussetzung, um Contextual Targeting zu ermöglichen.

Daher empfehlen wir allen unseren Publishern, den Relemind-Bot über die robots.txt-Datei zuzulassen.

Best Practices für die robots.txt Optimierung

Jeder Publisher sollte sich mit der robots.txt auseinandersetzen, um eine zielführende Indexierung seines/ihres Contents in den Suchmaschinen vorzugeben. Gerade für große Websites mit vielen Unterseiten empfiehlt es sich im Sinne des Crawl Budgets zu sondieren, ob und welche Inhalte ggf. über die robots.txt ausgeschlossen werden.

Achte bei der Pflege der robots.txt-Datei auf die folgenden Regeln:

- Schreibe alle Befehle untereinander.

- Nutze nach Möglichkeit jeden User Agent nur einmal und liste jeden dazugehörigen Befehl in einer neuen Zeile. Dies sorgt für mehr Übersichtlichkeit bei Dir und für die Crawler und minimiert mögliche Fehler.

- Bei Parametern in den URLs empfiehlt es sich, das * als Platzhalter zu nutzen, um so lediglich eine Zeile entsprechend zu pflegen.

- Beim Ausschließen von Dateien sollte die Funktion $ am Ende der Zeile genutzt werden. Dies erspart es, alle Dateien einzeln aufzuführen.

- Greifen mehrere Personen (Admins) auf die robots.txt zu, ist es hilfreich, die Textdatei mit Kommentaren zu versehen. Nutze hierfür die #-Funktion (#Kommentar), da Crawler Zeilen, die mit einer # beginnen, nicht beachten.

Mit gezieltem Ein- oder Ausschließen der entsprechenden User Agents trägst Du so dazu bei, nur für die Inhalte zu ranken, die die besten Potenziale haben.

Hinweis: Ausgeschlossene Inhalte können trotzdem in der Suche ranken, da die robots.txt nicht für die Deindexierung verantwortlich ist!

Des Weiteren ist es möglich, über die robots.txt die Sitemap an die Google Search Console oder den Bing Webmaster Tools einzureichen.

Nicht zuletzt durch das Aufkommen von KI-Bots hat die robots.txt-Datei einen großen Stellenwert in der Suchmaschinenoptimierung, da sich mit ihr gezielt Bots wie der GPTBot vom Crawling der eigenen Inhalte ausschließen lassen.

Sag Hi

Du möchtest Dein Blog oder Website monetarisieren? Kontaktiere jetzt unsere AdTech-Expert:innen!

Häufige Fragen zum Thema

Unsere Expert:innen teilen ihr Know-how und beantworten die robots.txt-FAQs.

Wo finde ich die robots.txt auf meiner Website?

Die robots.txt-Textdatei findest Du im Document-Root, also dem Hauptverzeichnis, einer Domain. Um zu wissen, was in der Datei steht, kannst Du einfach /robots.txt an Deine Hauptdomain anhängen: https://www.deinedomain.de/robots.txt

Was ist der Googlebot?

Der Googlebot ist der Bot der Google-Suchmaschine. Dieser sorgt dafür, dass Deine Inhalte gecrawlt und für die Suchmaschine indexiert werden, so dass Benutzer:innen der Suche Deine Inhalte auf den SERPs angezeigt werden.